t00ls python 查域名与签到每日+2 tubi 脚本 (web端) (0414更新)

※写此脚本的目的为希望土司大佬们一起多赚些tubi 可以多发些悬赏帖或不吝于购买其他大佬开发的优秀脚本与程式 一同让土司更热闹繁荣※

签到部分代码与思路请查看 https://www.t00ls.com/thread-55689-1-1.html

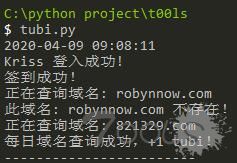

查询域名思路为

官方登入api --> 取出 formhash 与 cookie

官方查看 tubi 记录api --> 判断今天有无完成查询域名任务

若今天没有查询过 至域名列表站点 --> 随机爬取一个域名 (原本有考虑3~5字母乱数英文域名+后坠 虽然少一个请求 不过域名短多人使用容易重复 域名长容易找到死域名)

然后post 查找域名页面 判断回传内容 若查过或不存在则重新找一个域名查询 查到有+tubi为止

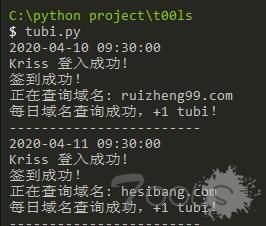

成功运行图片

此程式 为 python 3 开发 本人Python版本为 Python 3.6.8

需要安装 requests 与 BeautifulSoup 库

若为自动每日执行 则还要安装 schedule

pip install requests

pip install BeautifulSoup4

pip install schedule

之后自行填入帐号与密码与安全提问问答 即可使用

查询域名代码如下

import requests

import urllib.request

import json

import re

from datetime import datetime

from time import sleep

import random

from bs4 import BeautifulSoup

uname = 'Kriss' #帐号

pswd = 'password' #密码MD5 32位(小)

qesnum = 0 # 安全提问 参考下面

qan = '' # 安全提问答案

# 0 = 没有安全提问

# 1 = 母亲的名字

# 2 = 爷爷的名字

# 3 = 父亲出生的城市

# 4 = 您其中一位老师的名字

# 5 = 您个人计算机的型号

# 6 = 您最喜欢的餐馆名称

# 7 = 驾驶执照的最后四位数字

def delhtml(html):

html=str(html)

dr = re.compile(r'<[^>]+>',re.S)

dd = dr.sub('',html)

return dd

def toarr(html):

a = delhtml(html)

a=a.split( )

return a

def randdm():

page = random.randrange(1,84)

url = 'https://www.yooym.com/mi.php?Page='+ str(page)

req = requests.get(url)

soup = BeautifulSoup(req.text,'lxml')

tra = soup.find_all("tr",class_="")

del tra[0]

rkey= random.randrange(0, len(tra))

randm = toarr(tra[rkey])[0]

return randm

def tslogin(uname,pswd,qesnum,qan):

logindata = {'action': 'login', 'username': uname, 'password': pswd, 'questionid': qesnum, 'answer': qan}

rlogin = requests.post('https://www.t00ls.com/login.json',data = logindata)

rlogj = json.loads(rlogin.text)

if (rlogj["status"]!="success"):

print ("登入失败,请检查输入资料是否正确!")

else:

print(uname,"登入成功!")

return rlogin

today = datetime.now()

print(today.strftime("%Y-%m-%d %H:%M:%S"))

rlogin = tslogin(uname,pswd,qesnum,qan)

if (rlogin != "") :

rlogj = json.loads(rlogin.text)

tscookie = requests.utils.dict_from_cookiejar(rlogin.cookies)

tbreq = requests.get('https://www.t00ls.com/members-tubilog.json',cookies=tscookie)

tblog = json.loads(tbreq.text)

loglen = len(tblog["loglist"])

allreason =""

for i in range(loglen):

logday = tblog["loglist"][i]["timeline"]

logdatetime = datetime.strptime(logday, "%Y-%m-%d %H:%M:%S")

logdatetime = logdatetime.strftime("%Y-%m-%d")

todaydate = today.strftime("%Y-%m-%d")

if (logdatetime == todaydate):

allreason += tblog["loglist"][i]["reason"]

else:

break

if ("查询新com域名" in allreason):

print("今天已经查询过域名了!")

else:

while True:

domainurl = randdm()

print ('正在查询域名:',domainurl)

querydomainsubmit = urllib.parse.quote("查询")

postdata = {'formhash': rlogj["formhash"], 'querydomainsubmit': querydomainsubmit, 'domain': domainurl}

rpost = requests.post('https://www.t00ls.com/domain.html',data = postdata,cookies=tscookie)

if ("域名查询可以积累域名的信息,为进一步了解做准备,不要为了TuBi而查询。" in rpost.text):

print ("每日域名查询成功,+1 tubi!")

break

elif("Error:查询出错!域名不存在或接口有误,返回为空!" in rpost.text):

print ("此域名:",domainurl,"不存在!")

else:

print ("此域名:",domainurl,"已查询过!")

sleep(1)

print ('------------------------')

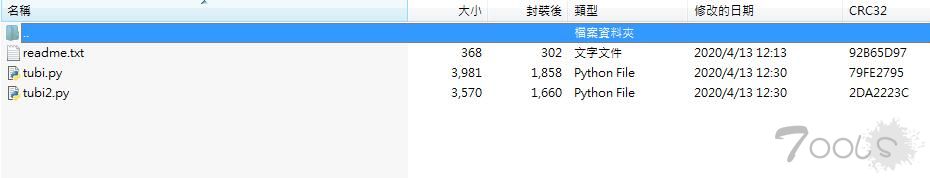

下载压缩档内容为 自动签到+查找域名 2合一脚本 分为单次版以及每日版~

有拿去用的兄弟希望可以给个回复 让我知道可以正常使用 或是有任何错误欢迎私信我

---------------0413更新-------------------

此为旧版 若需要请购买0414更新版

---------------0414更新-------------------

tubi.py 43 行

tuby2.py 41 行

原本為

page = random.randrange(1,200)

改為

page = random.randrange(1,84)

不影响使用 不过原本会容易超出页数 导致只爬取第一页域名 时间久了容易重复

请已购买的大佬私信我拿新版 或是自行更新

评论51次

连着手动七八十天的我,也用上了自动签到,不得不说真香

这种脚本自动签到 会不会被官方打击啊 我在想这个问题 最近挺多这种自动签到脚本的

之前都没签到过,这个脚本很实用呀

有没有无限刷t00ls币的脚本,哈哈哈

注册100个号,一个号一天2个tubi,一天就是200个,但是土币没啥用啊。还是要积分,没积分看不了文章

已经用上

有没有无限刷t00ls币的脚本,哈哈哈

手动逛逛帖子就忘了 云函数真香 等等表哥得url查询域名 云函数

等等表哥得url查询域名 云函数

基本上没去签到过。。。

一直手动签到,结果还漏掉了,????

每次手动三五天,就忘记签到了,想起来已经第二天了。但是自动化好像也得挂在服务器上吧

我就想说,会封号不,哈哈

@老司机 @afanti 没用过腾讯云函数..看有没有大佬愿意拿我这代码去用 或是给我一些时日

表哥,搞一下,最近在学别的没时间,云函数真是刷tubi利器,搞出来分享一下,我打赏。

@老司机 @afanti 没用过腾讯云函数.. 看有没有大佬愿意拿我这代码去用 或是给我一些时日

每天签到tubi就不少了,我是发现tubi够用,但是积分真的难上,求老哥来个腾讯云函数的查询url得域名的脚本。

老哥能不能安排一个腾讯云函数的查询url得域名的脚本,感谢

以后全是签到脚本 各种花式的

频率要控制好,不然账号很容易被封禁了。

@dm-xy 大部分是接官方接口的 应该还好 @5208853 有时间的话可以考虑 毕竟跟爬虫相关的python还是比较方便 @ice_age 爬域名的页面显示 共有16763条记录 应该还挺够用.. @faith 感谢大老支持啊

我还是用的你之前的版本,只签到就足够了,查域名可有可无

这么玩法 估计全网域名 很快被查一遍

最近在看怎么设置quantumultx,可以设置很多移动签到。大伙可以去看看。